La réduction du coût des requêtes en intelligence artificielle est devenue un enjeu central dans la compétition que se livrent les acteurs du secteur. L’optimisation de ce coût conditionne à la fois la rentabilité des entreprises spécialisées, l’accessibilité des services IA et l’évolution des modèles économiques sous-jacents. Cette guerre repose sur plusieurs leviers stratégiques, notamment les investissements en recherche et développement, l’adoption de stratégies concurrentielles axées sur la performance et l’optimisation des infrastructures, ainsi que l’impact de ces dynamiques sur l’ensemble du marché de l’intelligence artificielle.

Investissements et stratégies concurrentielles

La réduction du coût des requêtes passe avant tout par l’innovation. Les géants technologiques comme OpenAI, Google, Microsoft, Meta et Amazon consacrent des milliards de dollars à la recherche et au développement de modèles plus efficaces et de nouvelles infrastructures optimisées. L’objectif est double : réduire la consommation de ressources pour chaque requête et accélérer la vitesse d’exécution des modèles.

Microsoft, a notamment massivement investi dans OpenAI avec un apport de 13 milliards de dollars, et a également consacré plus de 75 milliards de dollars en 2024 à des infrastructures cloud spécialisées dans l’IA. Google, de son côté, a annoncé des dépenses similaires pour renforcer ses centres de données dédiés à son modèle Gemini. Meta, bien qu’axé sur l’open-source avec Llama, prévoit d’augmenter ses investissements dans l’IA en 2025.

Au-delà des infrastructures, les investissements se concentrent également sur l’optimisation algorithmique. Le développement de nouvelles architectures de réseaux neuronaux plus efficaces, comme les Sparse Transformers et le Mixture of Experts (MoE), permet d’améliorer les performances tout en réduisant la charge de calcul. De plus, les travaux sur la quantization des modèles, la knowledge distillation et l’utilisation de mémoires cache intelligentes visent à rendre l’exécution des modèles plus rapide et moins coûteuse.

L’approche propriétaire ou l’open-source : deux méthodes différentes

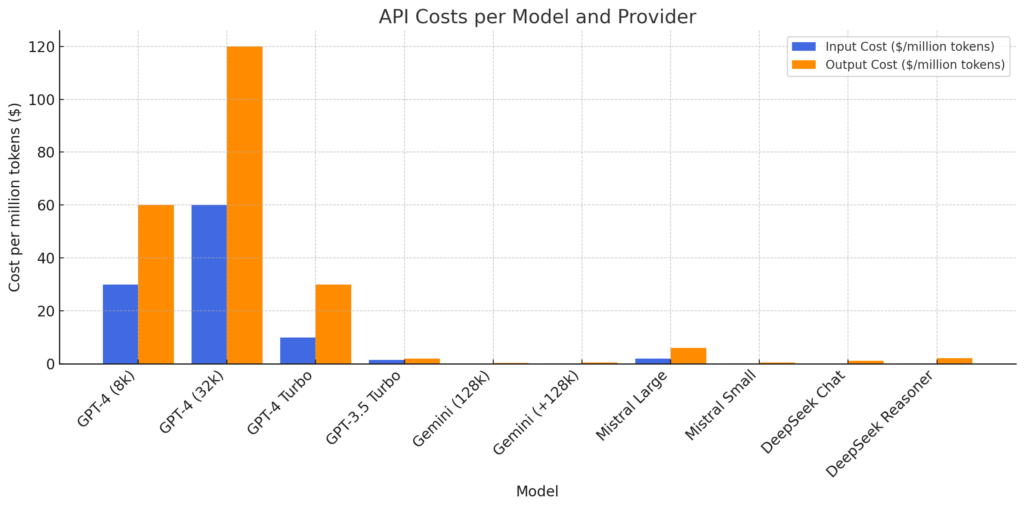

Face à ces enjeux, les entreprises adoptent deux stratégies distinctes. Certaines, comme OpenAI et Google, privilégient une approche propriétaire où les modèles restent sous leur contrôle exclusif. Cette approche leur permet d’optimiser leur rentabilité et de proposer des services payants à forte valeur ajoutée. Les coûts de leurs modèles sont relativement élevés, avec des API facturant jusqu’à 120 dollars par million de tokens pour les sorties textuelles (OpenAI GPT-4).

À l’inverse, d’autres entreprises, comme Meta et Mistral, misent sur l’open-source pour mutualiser l’innovation et réduire leurs coûts de développement. Meta, avec Llama, et Mistral, avec ses modèles plus légers et optimisés, permettent à d’autres entreprises et chercheurs de contribuer à l’amélioration des modèles tout en exploitant des infrastructures moins gourmandes en ressources.

Implications sur le marché et tarification des modèles

Le coût de la requête influence directement la tarification des services d’intelligence artificielle. OpenAI et Google, qui utilisent des infrastructures propriétaires coûteuses, facturent leurs services à des prix élevés. GPT-4, par exemple, est proposé à 60 dollars par million de tokens en entrée et 120 dollars en sortie, tandis que Gemini affiche un tarif plus compétitif, allant de 0,075 à 0,15 dollar par million de tokens en entrée et 0,30 à 0,60 dollar en sortie. En revanche, Mistral et DeepSeek se positionnent sur des offres plus abordables. Mistral Large est proposé à 2 dollars par million de tokens en entrée et 6 dollars en sortie, tandis que DeepSeek Chat facture 0,07 dollar en entrée et 1,10 dollar en sortie. Cette stratégie de prix plus accessibles permet aux entreprises et développeurs de choisir des modèles optimisés selon leurs besoins et budgets.

Figure 1 – Coûts de l’API de chaque modèle IA – Source : OpenAI, Google, Mistral, DeepSeek – Calcul de l’auteur

L’augmentation des coûts des requêtes pose un problème d’accessibilité. Si les prix des API continuent de croître, les petites entreprises et les startups risquent d’être exclues du marché, au profit des grandes entreprises capables d’absorber ces coûts. La concentration des infrastructures et des modèles d’IA dans les mains de quelques géants technologiques pourrait alors renforcer une situation d’oligopole, où seules les entreprises ayant les ressources financières suffisantes peuvent exploiter l’IA à grande échelle.

Lisez le premier article sur le sujet pour plus de contexte en cliquant sur ce lien: https://www.csactu.fr/le-cout-des-requetes-dans-intelligence-artificielle-definitions-et-enjeux-techniques/